MLPerf 是用于训练计算机执行机器学习任务所需时间的基准测试套件,周三发布的结果显示,总部位于英国布里斯托尔的初创公司 Graphcore 有了一个新的竞争者,与两者相比取得了可观的成绩 重量级人物,英伟达和谷歌。

五年前成立并融资 7.1 亿美元的 Graphcore 在任何 MLPerf 测试中都没有获得最高分,但它报告的结果在使用的芯片数量方面与其他两个相比具有重要意义。

此外,撇开谷歌提交的非商业化结果不谈,Graphcore 是唯一与 Nvidia 一起进入商业化结果前五名的竞争对手。

“这被称为 AI 的民主化,”Graphcore 软件主管 Matt Fyles 在新闻发布会上说。 他说,想要使用人工智能的公司“可以获得非常可观的结果作为 Nvidia 的替代品,而且随着时间的推移它只会变得更好,我们将继续推动我们的系统。”

“Nvidia 是我们追求的目标,”他说。 “我们必须成为 Nvidia 的替代品。”

MLPerf 测试套件是 MLCommons 的创建,MLCommons 是一个行业联盟,针对机器学习的两个部分(即所谓的训练)发布多次计算机年度基准评估,其中神经网络是通过在多个实验中改进其设置来构建的; 和所谓的推理,完成的神经网络在接收到新数据时做出预测。

周三发布的结果用于培训。

Graphcore 之前曾是 AI 领域的一群初创公司之一,其中包括拒绝接受基准测试的 Cerebras Systems 和 SambaNova Systems,声称不值得付出努力。 Cerebras 联合创始人兼首席执行官安德鲁·费尔德曼 (Andrew Feldman) 在 2019 年对 ZDNet 说,该公司“没有花一分钟时间研究 MLPerf”。

对于 Graphcore 来说,测试终于变得太重要了,不容忽视。 “我们有点不愿意做出贡献,”菲尔斯说。 但是,他说,公司意识到“我们必须站出来,我们必须展示我们的第二代具有竞争力,并且像其他人一样在所有规则、盒子和空间中发挥作用,”Fyles 说,他指的是公司的 Mk2 版本 它的智能处理单元芯片或 IPU 是 Nvidia GPU 的替代品。

“客户要求我们与 Nvidia 进行比较,他们不会要求我们与其他任何人进行比较,”Fyles 说。

事实上,MLPerf 的整个基准套件都源于一个基本的比较单位,可以称为 An Nvidia,就像米或开尔文一样。 参赛者运行的基准测试任务被选为那些平均需要一周时间才能在 Nvidia 的旧 V100 GPU 上训练的任务。

结果有点像大卫和歌利亚的情况,因为 Graphcore 落后于 Nvidia 和谷歌使用数千个芯片的巨大的超级计算机大小的系统。 此类系统在速度方面显示出绝对的前沿优势,可以通过来自主要供应商的工程计算机实现。

例如,为了训练 BERT 自然语言模型,一种产生类似人类文本的神经网络,谷歌的“TPU”芯片仅用了 17 秒就将程序训练到熟练程度。 Nvidia 的顶级机器用了 19 秒。 在此基准测试中,时间越短越好。

在十二分钟时,Graphcore 排在列表的后面。 然而,Graphcore 系统仅由两个 AMD EPYC 处理器和 64 个 Graphcore IPU 芯片组成。 谷歌的两台机器由 3,456 个 TPU 和 1,728 个 AMD 的 EPYC 处理器组成,其中一台由 2,048 个 TPU 和 1,024 个 EPYC 处理器组成。

Nvidia 的最佳结果在一个系统中使用了 4,096 个其最新的 GPU A100 和 1,024 个 EPYC,在另一个系统中使用了 1,024 个 A100 和 256 个 EPYC。 (所有带有专用加速器的机器都带有一个主机微处理器,它负责各种事情,例如将机器学习任务分派给加速器。)

Graphcore 的 BERT 得分是双处理器 AMD 系统最快的时间,紧随其后的竞争对手是基于 Nvidia 的系统,耗时整整 21 分钟,尽管该系统仅使用了 8 个 Nvidia 的 A100 芯片。

您可以在 MLCommons 发布的一个大电子表格中查看所有结果。

Graphcore 的系统不仅使用更少的 IPU 芯片,而且使用更少的 AMD 主机处理器,这一事实对公司来说意义重大。 Graphcore 强调其 IPU 芯片可以独立于主机微处理器的数量进行扩展,以在需要的地方提供强大的功能。

在 BERT 基准测试的一个单独版本中,称为“开放”提交,允许提交者调整他们的软件代码以生成神经网络的非标准实现,Graphcore 能够将其在 BERT 上的训练时间减少到刚刚超过 九分钟。

同样,在名为 ImageNet 的图像识别测试中,使用标准的 ResNet-50 神经网络,Graphcore 系统名列第四,训练该系统需要 14.5 分钟,而 Nvidia 计算机的训练时间为 40 秒。 但是 Graphcore 机器仅依赖 8 个 AMD CPU 和 64 个 Graphcore IPU,而 620 个 AMD 芯片和 2,480 个 Nvidia A100 部件。

由于 Graphcore 的系统目前正在出货,Graphcore 的竞争变得更加有趣,这是除 Nvidia 系统之外唯一实际出售的处理器架构。 谷歌的 TPU 机器是即将推出的技术的“预览版”。 另一组在 BERT 和 ImageNet 上获得最高分的提交,来自中国广东深圳的科研机构鹏程实验室,被认为是一个研究项目,实际上并不可用。

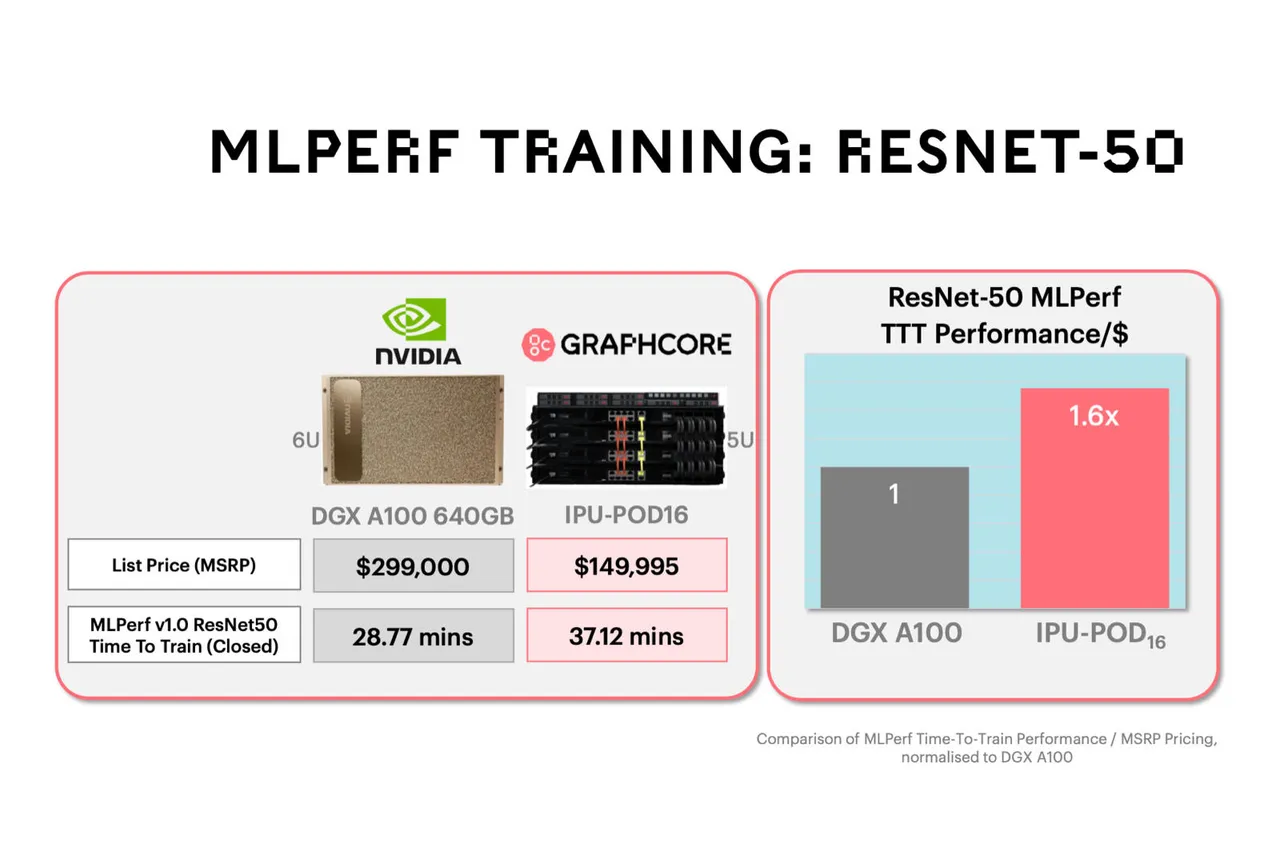

Graphcore 向记者强调了获得可观结果的经济优势,即使它们不是绝对最快的。 该公司将其 IPU-POD16 的成本(根据一份报价为 149,995 美元)与据估计最接近的 Nvidia 提交(称为 DGX A100 的八 GPU 系统)的成本估计为 299,000 美元进行了比较。

Nvidia 系统在 BERT 上的得分比 IPU 系统好,大约 21 分钟对 Graphcore 34 分钟,但对 Graphcore 来说,经济优势远远超过时间差异。

“这些系统现在以非常高的性能提供更好的成本,”Fyles 说。 “当我们扩大规模提交时,我们将获得其中一些非常低的数字,”指的是最高分

Graphcore 目前最大的系统 IPU-POD64 由 64 个独立的加速器芯片组成。 该公司计划今年提供带有 128 和 256 芯片的型号。 该公司希望在未来将这些更大的系统作为其参赛作品的一部分。 Fyles 指出 IPU-POD 可以有多达 64,000 个 IPU 芯片。

目前,“我们可以以与 DGXA100 相同的价格提供更多加速器,这是我们的信息,”Graphcore 的 Fyles 说。 该公司将经济等式描述为“每美元训练性能的时间”,认为它是一个人使用 DGX 获得的 1.3 倍。

然而,Nvidia 告诉 ZDNet Graphcore 正在“挑选”它的比较。

“这不是真的,”Nvidia 产品管理和营销高级总监 Paresh Kharya 在谈到 Graphcore 的经济比较时说。

该公司指出了一个类似的 8 路 A100 系统,同样配备了两个来自 Supermicro 的 AMD 芯片,其成本仅为 125,000 美元,但在 ResNet-50 和 BERT 上的得分均优于 Graphcore IPU-POD16。 Kharya 指出,众多 DGX 供应商的成本可能相差很大。

“这真的是一个苹果和橘子的案例,”他谈到 Graphcore 时说。 “他们正在将 16 芯片系统与我们的 8 芯片系统进行比较,即使使用他们的 16 芯片,它们仍然更慢。”

Kharya 补充说,Nvidia 的优势是在 MLPerf 基准测试的所有八项测试中都表现出色,这表明该机器的适用范围很广。

“客户不仅仅是部署基础设施来做一件事,BERT 和 ResNet-50;他们正在部署以运行他们的基础设施五年,”Kharya 说。 “投资回报率来自几件事,运行许多不同事物的能力,高利用率,以及软件的高生产力。”

“如果你只能经营几样东西,你就必须降低价格来吸引顾客购买,”他说。

对于 Nvidia,基准测试证实其在商用系统的绝对最快时间方面遥遥领先。 该公司指出,它在 MLPerf 的所有八项任务中都得到了加速,并强调了当所有提交的分数除以所使用的芯片数量时,它所谓的“大规模的相对每芯片性能”。

Nvidia 的收益不仅建立在 A100 等巨大的 GPU 芯片之上,还建立在多年改进其软件功能的基础上。 基准性能中强调了多项技术,包括 Nvidia 编写的用于在芯片之间有效分配任务的软件,例如 CUDA Graphs 和 SHARP。

Graphcore 在其自己的软件 Poplar 上取得了进展,正如提交的公开结果所示,尽管该软件平台仍然比 Nvidia 的软件平台年轻很多年,所有初创公司都是如此。

对于谷歌来说,最终吹嘘的权利来自于拥有“持续的绩效领导力”,正如该公司的谷歌云研究人员在一篇博客文章中所说的那样。 谷歌对其 TPU 版本 4 的预览在谷歌竞争的六项测试中的四项中获得了最高成绩。 与 Graphcore 一样,谷歌将其比较重点放在 Nvidia 的结果上。

Fyles 说,随着 Graphcore 计划再次进入 MLPerf 另一部分的漏洞,这场战斗将在今年继续进行,并获得更多基准测试结果。

除了 Graphcore 的条目外,最新的 MLPerf 工作在其他几个方面也值得注意。

该测试新增两项测试,一项针对语音转文本任务,基于约翰霍普金斯大学 2015 年开发的 LibriSpeech 数据集,使用广泛部署的 RNN-T 神经网络模型; 另一个用于所谓的图像分割,根据去年在明尼苏达大学、卡尔顿学院和北达科他大学开发的用于 CT 扫描中肿瘤检测的 KiTS19 数据集,挑选出图片中的对象。

该测试套件还放弃了之前的两个测试 GNMT 和 Transformer,取而代之的是类似的自然语言任务 Google 的 BERT。

新的基准套件还增加了 7 个新的提交者,并报告了 650 个单独的结果,而去年报告了 138 个。

另外:随着 AI 计算机变得越来越大,Nvidia 和 Google 声称在 MLPerf 基准测试中吹嘘自己的权利

MLCommons 主席 David Kanter 表示,基准套件是“整个行业的晴雨表”,称其“比摩尔定律更令人兴奋”,这是晶体管改进的历史衡量标准。

“你可以看到,自 MLPerf 培训开始以来,我们已经成功地将性能提高了 27 倍,”Kanter 说。 坎特说,准确性也同时提高了。

“重要的是,不仅要将这些视为技术问题,还要将其视为影响人们现实生活的事情,”担任 ML Commons 机器学习培训工作组主席的 Victor Bittorf 说。

似乎有公司和机构在其购买决策中使用 MLPerf 套件的趋势。 Nvidia 援引全球最大的合同芯片制造商台积电的话说,在购买计算机以运行 AI 用于芯片制造时,这些测试是“我们决策的一个重要因素”。

Nvidia 的 Kharya 表示,虽然测试具有代表性,但基准测试和现实世界的实现之间存在重要差异,如果基准 ResNet-50 等小型模型的大小微不足道,那么现实世界的实现将使用超级计算机。

相反,这些超级计算机正在处理具有一万亿个或更多参数的神经网络,并且仍然需要数天或数周的时间来训练。

“规模真的很重要,”Kharya 说。 “我们可以在不到一分钟的时间内在 Selene 上训练 BERT,”这台超级计算机采用英特尔的 A100 GPU 和 AMD EYPC 微处理器构建。 “但是即使在 Selene 上训练 GPT-3 模型也需要两周多的时间,”Kharya 说,他指的是初创公司 Open-AI 的最先进的语言模型。

Kharya 的观点是,Nvidia 的性能提升将在现实世界中得到放大。 他说,在 MLPerf 中使用的小型 BERT 模型上,其 GPU 性能提速三倍,这将转化为需要数周至数月训练的项目提速三倍。

他说,这意味着 Nvidia 的进步可以大幅减少最大的培训项目。

“在现实世界中,一分钟与一小时的差异看起来要大得多,”Kharya 说。

MLCommons 在 11 月推出了一组单独的基准测试,用于运行机器学习任务的高性能计算或 HPC 系统。

如此宏大的规模确实是 Graphcore 和 Cerebras 以及其他公司所关注的地方。

Graphcore 的 Fyles 说:“在整个领域,非常大的公司正在研究非常大的语言模型。” “这将过渡到其他非常大的模型,其中结合了不同类型的模型,例如专家的混合体。”

对于包括 Graphcore 在内的初创公司来说,隐含的希望是,这些复杂的任务最终将使他们超越仅仅与 Nvidia 在基准测试上竞争,而是改变 AI 的范式以使其成为自己的优势。

“如果我们只有一个 GPU 模型,如果我们所做的只是运行 GPU 模型,那么我们要做的就是与 GPU 竞争,”Fyles 说。 “我们正在与实验室合作,让他们了解 IPU 的各种用途,而不仅仅是与 Nvidia 进行比较。”