人工智能的机器学习形式越来越倾向于越来越大的神经网络。 最大的神经网络,例如谷歌的 Pathways Language Model,按其参数或“权重”衡量,权重超过 5000 亿,每增加一个权重都会增加使用的计算能力。

如何应对不断增加的规模? 一方面拥有更强大的芯片,另一方面也通过节食一些软件。

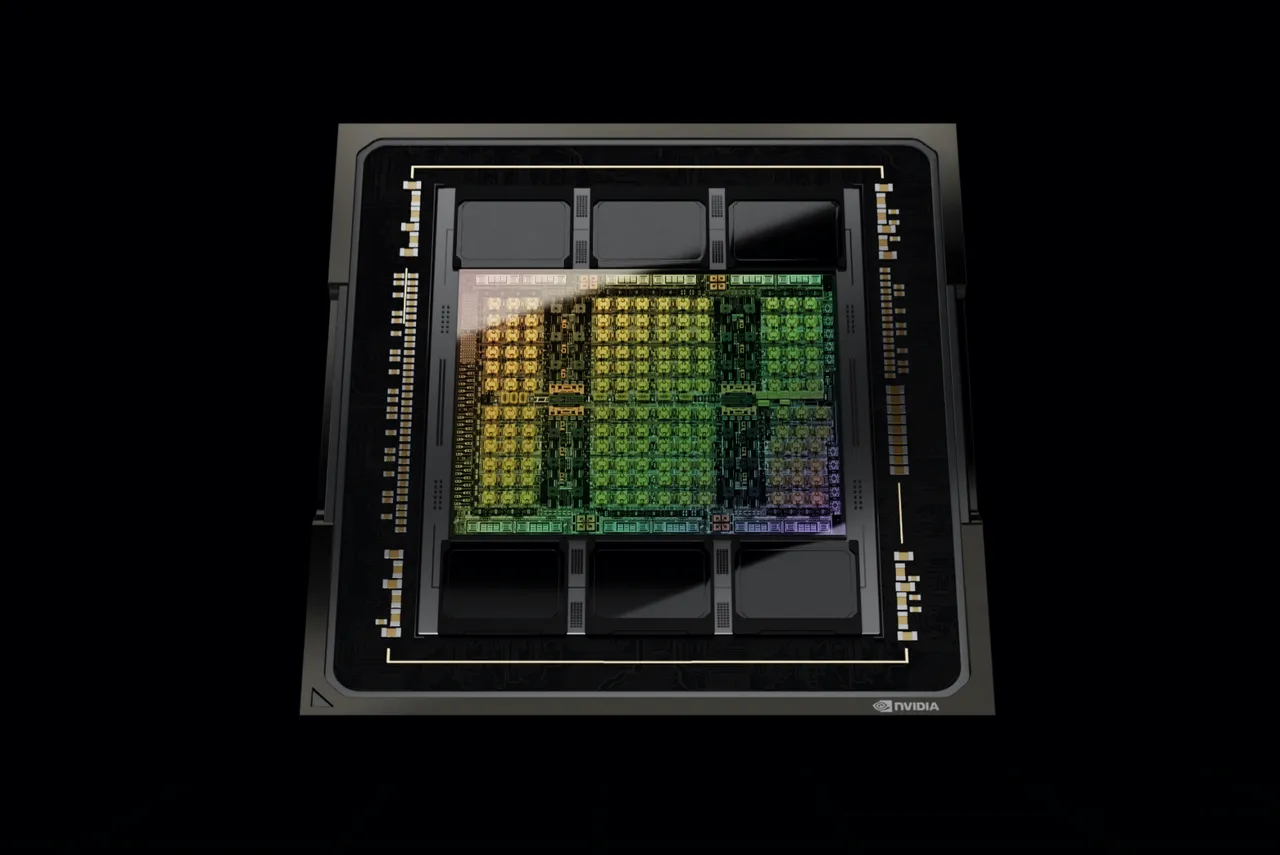

周四,运行 MLPerf 测试的联盟 MLCommons 展示了神经网络运行速度的最新基准测试。 报告的结果具有一些重要的里程碑,包括 3 月份公布的 Nvidia“Hopper”GPU 的首个基准测试结果。

与此同时,中国云计算巨头阿里巴巴首次提交了整个计算机集群作为一台机器的报告结果,在可实现的总吞吐量方面击败了其他提交的报告。

一家名为 Neural Magic 的初创公司展示了它如何能够使用“剪枝”(一种切除部分神经网络的方法)来实现更精简的软件,其性能与普通程序差不多,但 需要更少的计算能力。

Neural Magic 的产品工程负责人 Michael Goin 在接受 ZDNet 采访时说:“我们都在训练这些令人尴尬的强力密集模型,”他指的是 Pathways 等巨型神经网络。 “我们都知道必须有更好的方法。”

称为 Inference 2.1 的基准测试代表了 AI 机器学习方法的一半,当训练有素的神经网络被输入新数据并且必须产生结论作为其输出时。 该基准衡量计算机为包括 ImageNet 在内的许多任务生成答案的速度有多快,其中神经网络面临的挑战是将多个标签之一应用到描述照片中物体(例如猫或狗)的照片上。

芯片和系统制造商竞相看他们在一秒钟内处理的照片数量等指标上能做得多好,或者他们能得到多低的延迟,将请求发送到计算机的总往返时间以及 要返回的预测。

此外,一些供应商提交的测试结果显示了他们的机器消耗了多少能源,随着数据中心变得越来越大,消耗大量电力,这一因素变得越来越重要。

MLCommons 单独报告的另一套基准测试结果涵盖了问题的另一半,即训练神经网络,最新一轮是在 6 月。

推理 2.1 报告遵循 4 月份的上一轮推理基准。 这一次,报告的结果仅与数据中心和“边缘”中运行的计算机系统有关,“边缘”一词已经涵盖了传统数据中心机器以外的各种计算机系统。 为数据中心结果发布了一个电子表格,为边缘发布了另一个电子表格。

最新的报告没有包括被称为 TinyML 的超低功耗设备和移动计算机的结果,这些设备在 4 月份的报告中被归为数据中心。

总之,基准测试收到了 5,300 份来自芯片制造商和合作伙伴以及 Neural Magic 等初创公司的提交。 这比 4 月份报告的上一轮增加了近 40%。

与过去一样,Nvidia 在众多任务中加速推理方面获得了最高分。 Nvidia 的 A100 GPU 在提交的数量中占据主导地位,通常情况下,它与英特尔和 Advanced Micro Devices 的处理器集成在由一群合作伙伴构建的系统中,包括阿里巴巴、华硕、微软 Azure、Biren、戴尔、富士通、技嘉、 H3C、Hewlett Packard Enterprise、Inspur、Intel、Krai、Lenovo、OctoML、SAPEON 和 Supermicro。

Nvidia 自己在结果的数据中心部分提交了两个条目,其中 Hopper GPU 被指定为“H100”。 一个系统配备了 AMD EPYC CPU 作为主处理器,另一个系统配备了 Intel Xeon CPU。

在这两种情况下,值得注意的是,Hopper GPU 尽管是单芯片,但得分非常高,在许多情况下优于具有两个、四个或八个 A100 芯片的系统。

Hopper GPU 预计将于今年晚些时候上市。 Nvidia 表示,预计将在 2023 年初推出即将推出的“Grace”CPU 芯片,该芯片将与英特尔和 AMD CPU 竞争,并且该芯片将成为系统中 Hopper 的配套芯片。

与 Nvidia 一起,移动芯片巨头高通公司展示了其 Cloud AI 100 芯片的新成果,这是一种为机器学习任务构建的新型加速器。 高通本轮增加了新的系统合作伙伴,包括戴尔、惠普企业和联想,并增加了使用其芯片的提交总数。

虽然芯片制造商和系统制造商之间的较量往往占据头条新闻,但越来越多聪明的研究人员出现在 MLPerf 中,他们提出了可以从相同硬件中获得更多性能的新颖方法。

过去的例子包括 OctoML,这家初创公司正试图将 DevOps 的严谨性引入运行机器学习。

这一次,成立四年、获得风险投资支持的初创公司 Neural Magic 提供了一种有趣的方法。 该公司的技术部分来自麻省理工学院学者 Nir Shavit 和前麻省理工学院研究科学家兼公司 CTO Alex Matveev 的研究。

这项工作表明在减少神经网络所需的计算方面可能取得突破。

Neural Magic 的技术训练神经网络并找出哪些权重可以闲置。 然后它将这些权重设置为零值,这样它们就不会被计算机芯片处理。

这种称为修剪的方法旨在去除树上不需要的分支。 然而,它也是深度学习更广泛趋势的一部分,这种趋势可以追溯到几十年前,即所谓的“稀疏性”。 在机器学习的稀疏方法中,某些数据和程序的某些部分可被视为出于实际目的的不必要信息。

另一种称为量化的技术将一些数字转换为更简单的表示形式。 例如,一个 32 位的浮点数可以压缩成一个 8 位的标量值,这样更容易计算。

Neural Magic 技术充当一种转换工具,数据科学家可以使用它来自动找到可以在不牺牲准确性的情况下安全丢弃的神经网络部分。

根据 Neural Magic 的项目负责人的说法,这样做的好处不仅是减少了处理器必须处理的计算量,还减少了 CPU 必须从芯片外部转移到外部存储器(例如 DRAM)的数量,这会减慢速度 一切。

Neural Magic 的 Goin 说:“你删除了 90% 的参数,你就删除了 90% 的 FLOPs,”他指的是“每秒浮点运算”,这是衡量处理器运行计算速度的标准。

此外,“CPU 很容易限制内存带宽,”Goin 说。 “移动大张量需要大量内存带宽,而 CPU 不擅长,”Goin 指出。 张量是组织神经网络权重值的结构,必须保留在内存中。

Neural Magic 使用配备两个运行频率为 2.3 GHz 的英特尔至强 8380 芯片的系统提交了数据中心和边缘类别的结果。 Neural Magic 选择的类别是数据中心和边缘的“开放”类别,允许提交者使用不符合基准测试标准规则的独特软件方法。

该公司使用其名为 DeepSparse 的新型运行时引擎来运行谷歌开发的 BERT 自然语言处理神经网络版本。

通过修剪 BERT 网络,大大减少的权重大小可以保存在 CPU 的本地内存中,而不是从芯片外转移到 DRAM。

现代 CPU 具有称为高速缓存的宽敞本地内存,可以存储经常使用的值。 至强等大多数服务器芯片上所谓的三级缓存可以容纳数十兆字节的数据。 Neural Magic DeepSparse 软件将 BERT 程序的文件大小从 1.3 GB 减少到 10 MB。

“既然权重可以非常小,那么你可以将它们放入缓存中,更具体地说,将多个操作放入这些不同级别的缓存中,以获得更有效的内存带宽,而不是被卡在 DRAM 中,”Goin 告诉 ZD网。

DeepSparse 程序显示每秒处理的查询数量比许多标准系统高得多。

与遵循严格软件规则的 ResNet 数据中心测试的“封闭”版本结果相比,Neural Magic 的单个英特尔 CPU 在多个 Nvidia 加速器(包括惠普企业和 Nvidia 本身)的提交中名列前茅。

在更具代表性的比较中,配备两个英特尔至强处理器的戴尔 PowerEdge 服务器每秒仅处理 47.09 个查询,而其中一台 Neural Magic 机器每秒能够产生 928.6 个查询,速度提高了一个数量级。

Neural Magic 的 DeepSparse 使用的 BERT 版本移除了 60% 的权重,其中 10 层人工神经元被归零,只剩下 14 层,而戴尔计算机正在处理标准的完整版本。 尽管如此,Neural Magic 机器仍然产生了与标准的 99% 预测准确度测量值相差 1% 以内的预测。

Neural Magic 发表了自己的博客文章,描述了这一成就。

Neural Magic 的工作对人工智能和芯片社区具有广泛的影响。 如果可以调整神经网络以减少对资源的需求,它可能会提供一种方法来阻止机器学习不断增加的功率预算。

“当你考虑部署盒子进行推理的实际成本时,在运行时引擎上有很多工作要做,但就机器学习社区而言,在获得 ML 工程师和数据方面还有更多工作要做 科学家们有更多工具来优化他们的模型,”Goin 告诉 ZDNet。

“我们有一个很大的路线图,”Goin 说。 “我们希望向更多人开放优化。”

“如果我们可以将模型修剪到其权重的 95%,为什么不是每个人都这样做呢?” 戈因说。

Goin 说,稀疏性“将像量化一样,每个人都会接受,我们正处于它的边缘。”

对于芯片行业而言,Neural Magic 能够展示 X86 芯片的优势这一事实意味着更多种类的芯片方法可以用于推理和训练。 Neural Magic 今年早些时候与英特尔 x86 CPU 的最大竞争对手 Advanced Micro Devices 合作,表明这项工作不仅限于英特尔品牌的芯片。

去年,英特尔的科学家们在着手制作经过修剪的 BERT 模型时甚至求助于 Neural Magic。 在以色列英特尔实验室的 Ofir Zafrir 及其同事发表的一篇论文中,将神经魔法方法(称为“渐进幅度修剪”)与称为“学习率倒带”的英特尔方法相结合。 作者报告说,两者的结合导致准确性损失最小。

Goin 预计 Neural Magic 将在未来添加基于 ARM 的系统。 “我希望能够直接从这里的 MacBook Pro 进行 MLPerf 提交,”Goin 说,他指的是 Mac 的 M 系列芯片,它使用 ARM 指令集。

Goin 表示,Neural Magic 目前拥有近 40 名员工,去年筹集了 3000 万美元的风险投资,并拥有“通往 2024 年的跑道”。 该公司通过出售使用 DeepSparse 运行时引擎的许可证将其代码货币化。 “我们看到了对自然语言处理和边缘计算机视觉等事物的最大兴趣,”Goin 说。

Goin 表示,零售业是一个非常有前景的用例领域,制造业和物联网应用也是如此。 但适用性实际上是世界上任何数量不起眼的系统,它们没有花哨的加速器,而且可能永远不会有这样的硬件。 “有些行业已经存在了几十年,到处都有 CPU,”Goin 观察到。 “你去星巴克的后屋,他们的壁橱里有一架服务器。”

在 MLPerf 的其他惊人的第一中,云计算巨头阿里巴巴是第一家也是唯一一家提交由多台机器组成的系统的公司,而这通常是针对单台机器的竞争。

阿里巴巴提交了五个系统,由两到六个节点的变体组成,混合运行英特尔至强和英伟达 GPU。 一个名为 Sinian vODLA 的阿里巴巴软件程序自动将神经网络的任务分配给不同计算机的不同处理器。

最显着的特点是,Sinian 软件可以即时决定将神经网络的任务分配给不同类型的处理器,包括各种 Nvidia GPU,而不仅仅是一个,因此每个处理器的能力差异不是一个问题 障碍而是潜在的优势。

“这就是未来,异构计算,”阿里巴巴负责异构计算的首席科学家张伟峰在接受 ZDNet 采访时说。

阿里云服务器的基准测试结果显示了一些令人瞠目结舌的数字。 在 BERT 语言任务中,一个总共具有 32 个 Nvidia GPU 的四节点系统能够每秒运行超过 90,000 个查询。 这比封闭式数据中心机器类别中的最高获奖作品快 27%,浪潮的单台机器使用 24 个 GPU。

“这项工作的价值可以概括为简单、高效和经济,”张告诉 ZDNet。

在第一个分数上,易用性,“我们可以抽象出计算[硬件]的异构性,使它更像是一个巨大的资源池”,张解释说。

如何使多台计算机作为一台计算机运行是计算机科学的一个领域,随着超大型神经网络的兴起,它显示出新的相关性。 然而,开发软件系统以在多台计算机之间划分工作是一项艰巨的任务,超出了大多数 AI 工业用户的能力范围。

Zhang 指出,Nvidia 已经找到了对其 GPU 进行分区以使其成为多租户芯片的方法,称为“MIG”,一种多实例 GPU。

他说,这是一个开始,但阿里巴巴希望超越它。 “MIG 将 GPU 划分为七个小组件,但我们希望对此进行概括,以超越物理限制,根据实际需求使用资源分配,”张解释道。

“如果你正在运行 ResNet-50,也许你只使用了 10 TOPs 的计算,”意思是,每秒数万亿次操作。 他说,即使是其中一个 MIG 也可能超出用户的需求。 “我们可以进行更细粒度的分配,”与 Sinian 一起,“这样也许 100 个用户可以同时使用 [单个 GPU]。”

关于第二点,效率,张指出,大多数筹码很少被尽可能多地使用。 由于内存和磁盘访问时间以及带宽限制等多种因素,GPU 的利用率有时会低于 50%,这是一种浪费。 Zhang 指出,有时,这一比例低至 10%。

“如果你使用一台带有 8 个 PCIe 插槽的机器”将芯片连接到内存,张说,“你将使用不到 50% 的资源,因为网络是瓶颈。” 通过首先处理网络问题,“我们能够在这次提交中实现更高的利用率。”

也许同样重要的是,随着机器扩展到越来越多的芯片,单个盒子的功耗成为一个棘手的问题。 “假设你可以在你的主板上为 GPU 构建 32 个插槽,”Zhang 解释说,“你可能会得到相同的结果,但是如果主板上有 32 个 PCIe 插槽,你的电源将增加三倍。”

他说,就尝试实现绿色计算而言,这是一个大问题。

第三个问题,经济学,阿里巴巴的客户如何购买实例。 “这对我们很重要,因为我们有很多设备,而不仅仅是 GPU,我们希望利用所有这些设备,”张说。 “我们的客户说他们想使用最新的 [芯片],但这可能并不是他们所需要的,因此我们希望确保池中的所有东西都可供用户使用,包括 A100 [GPU] 以及较旧的技术。 “

“只要我们解决他们的问题,给他们更多经济的资源,这可能会为我们的客户节省更多的钱——这基本上是我们做这件事的主要动力。”

如果您想深入了解有关阿里巴巴工作的更多细节,可以从 Zhang 在 6 月国际计算机体系结构研讨会上发表演讲时使用的一组幻灯片开始。

阿里巴巴的工作特别有趣,因为一段时间以来,计算机网络领域的专家一直在谈论位于局域网后面的第二个网络,一种专为深度学习的大量带宽需求而设计的专用 AI 网络。

从这个意义上说,阿里巴巴的网络提交和 Neural Magic 的稀疏性都在处理内存访问和带宽的总体问题,该领域的许多人认为这比计算部分本身对深度学习来说是更大的障碍。