Apple 已经开始推出其酝酿已久的增强现实 (AR) 城市指南,它使用摄像头和 iPhone 的显示屏向您展示您要去的地方。 它还显示了 Apple 对 AR 积极使用的未来展望。

透过镜子,我们看得很清楚

新的 AR 指南可在伦敦、洛杉矶、纽约市和旧金山使用。 现在,我不太相信大多数人在穿梭于旅游景点时,会觉得在空中晃动他们价值 1,000 多美元的 iPhone 时特别舒服。 尽管我敢肯定有些人真的希望他们这样做(而且他们并不都在 Apple 工作)。

但是很多人会尝试一下。 它有什么作用?

[通过 Computerworld 的时事通讯了解最新的 IT 思想领导力、见解、操作方法和分析。 ]

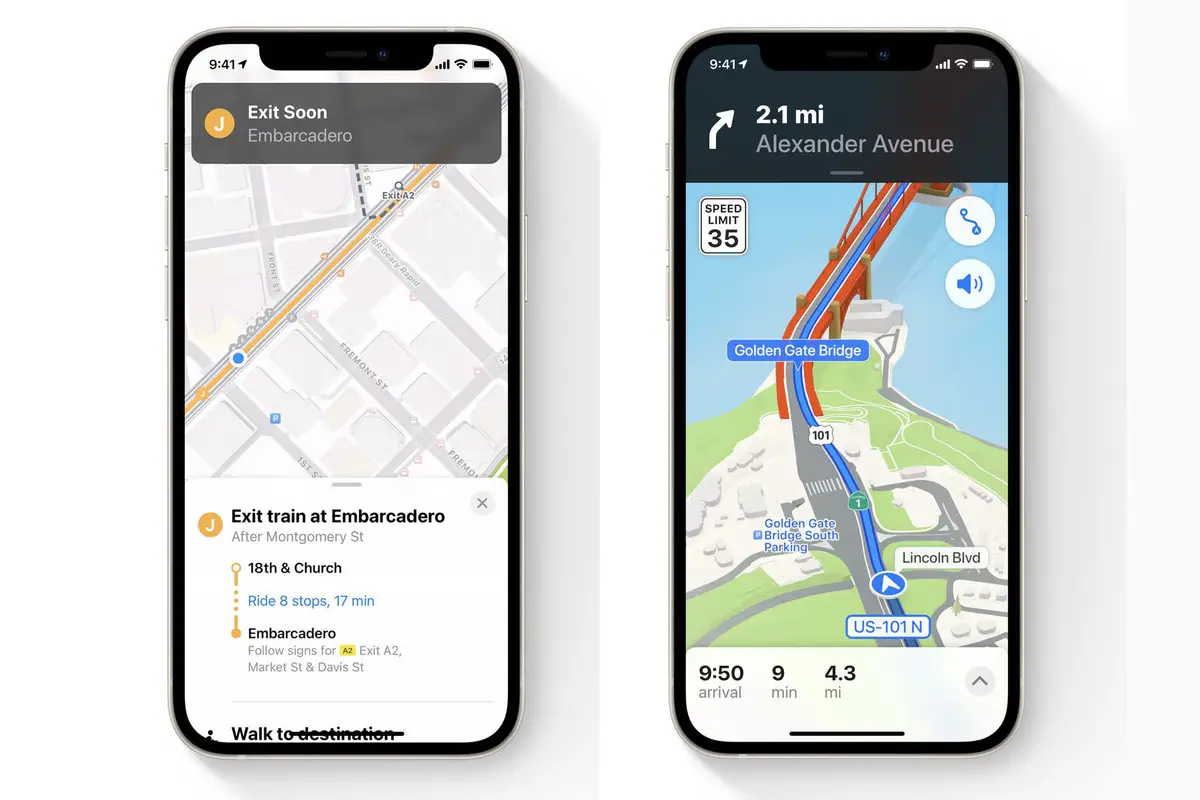

Apple 在 6 月的 WWDC 上发布 iOS 15 时宣布计划在 AR 中引入逐步步行指导。 这个想法很强大,并且是这样工作的:

拿起你的 iPhone。

将它指向您周围的建筑物。

iPhone 将分析您提供的图像以识别您所在的位置。

然后,地图将生成高度准确的位置以提供详细的指示。

为了在英国说明这一点,Apple 突出显示了邦德街站的图像,其中有一个大箭头指向牛津街。 图片下方的文字让您知道 Marble Arch 车站距离酒店仅 700 米。

这都是有用的东西。 就像 Apple 所做的很多事情一样,它利用了 Apple 的一系列较小的创新,特别是(但不完全)A 系列 Apple iPhone 处理器中的神经引擎。 为了识别摄像头看到的内容并提供准确的方向,Neural Engine 必须使用 Apple 开发的大量机器学习工具。 其中包括图像分类和对齐 API、轨迹检测 API,以及可能的文本识别、检测和地平线检测 API。 那是纯图像分析部分。

这与 Apple 的设备上位置检测、地图数据和(我怀疑)其现有的街景数据库相结合,可以为用户提供到所选目的地的近乎完美的准确方向。

这很好地说明了您已经可以在 Apple 平台上通过机器学习实现的各种事情——电影模式和实时文本是最近两个更出色的例子。 当然,不难想象将手机对准路牌,同时以这种方式使用 AR 指示来接收文本的即时翻译。

Apple 负责机器学习的高级副总裁 John Giannandrea 在 2020 年告诉 Ars Technica 时谈到了它的重要性:“有一大堆由机器学习提供支持的新体验。 这些是诸如语言翻译或设备上的听写之类的东西,或者我们关于健康的新功能,比如睡眠和洗手,以及我们过去发布的关于心脏健康的东西等等。 我认为 iOS 中我们不使用机器学习的地方越来越少。”

Apple 的一系列相机技术说明了这一点。 即使在事件发生后,您也可以在肖像或电影模式下编辑图像也说明了这一点。 所有这些技术将协同工作,提供我们预计公司将于明年开始推向市场的 Apple Glass 体验。

但这只是可能性的冰山一角,随着 Apple 继续扩大其为开发人员提供的可用机器学习 API 的数量。 现有的 API 包括以下内容,所有这些都可以通过与 CoreML 兼容的 AI 模型进行扩充:

图像分类、显着性、对齐和相似性 API。

对象检测和跟踪。

轨迹和轮廓检测。

文本检测和识别。

面部检测、跟踪、地标和捕获质量。

人体检测、身体姿势和手部姿势。

动物识别(猫和狗)。

条形码、矩形、地平线检测。

用于分析视频帧之间对象运动的光流。

人物分割。

文件检测。

七个自然语言 API,包括情感分析和语言识别。

语音识别和声音分类。

Apple 会定期增加此列表,但开发人员已经可以使用大量工具来增强应用程序体验。 这个简短的应用程序集合展示了一些想法。 最近为机上工作人员部署了 12,000 部 iPhone 的达美航空公司还制作了一款增强现实应用程序来帮助机舱工作人员。

创新的垫脚石

我们都认为苹果明年会推出某种 AR 眼镜。

届时,Apple 新推出的地图功能肯定会展示其对这些事物的部分愿景。 它还让公司有机会使用私人设备上的分析来将其现有的地理位置图像集合与用户收集的图像进行比较,这只会帮助它开发越来越复杂的 ML/图像交互。

我们都知道,样本量越大,人工智能越有可能提供好的结果,而不是垃圾结果。 如果这是意图,那么苹果肯定希望说服其十亿用户使用它引入的任何东西来提高它在地图中使用的机器学习系统的准确性。 毕竟,它喜欢在之前制作的垫脚石的背面建造下一块垫脚石。