一、AI 数字人克隆技术的核心实现路径

AI 数字人技术通过多模态数据融合与深度学习模型,实现自然人形象与表达的数字化复刻。以当前主流技术方案为例,其核心流程可拆解为三个技术环节:

1.视觉形象建模

数据采集:通过 10-20 秒的单目视频输入(含多角度面部动作),利用计算机视觉算法提取 68面部关键点、肌肉运动向量及形体特征参数模型训练:基于 3D 人脸重建技术,构建包含皮肤纹理、毛发动力学、微表情细节的高精度数字孪生体,误差率可控制在 0.5mm 以内

2.语音声学建模

音频特征提取:对 1 分钟语音样本进行声谱分析,捕捉基频、共振峰、韵律节奏等 300 + 声学特征

情感迁移模型:结合 Transformer 架构实现语音情感维度(如愉悦度、激活度)的参数化表达,支持方言口音的自适应生成

技术延伸:跨境电商场景中,通过声纹迁移 + 机器翻译的级联模型,实现多语言语音的自然转换

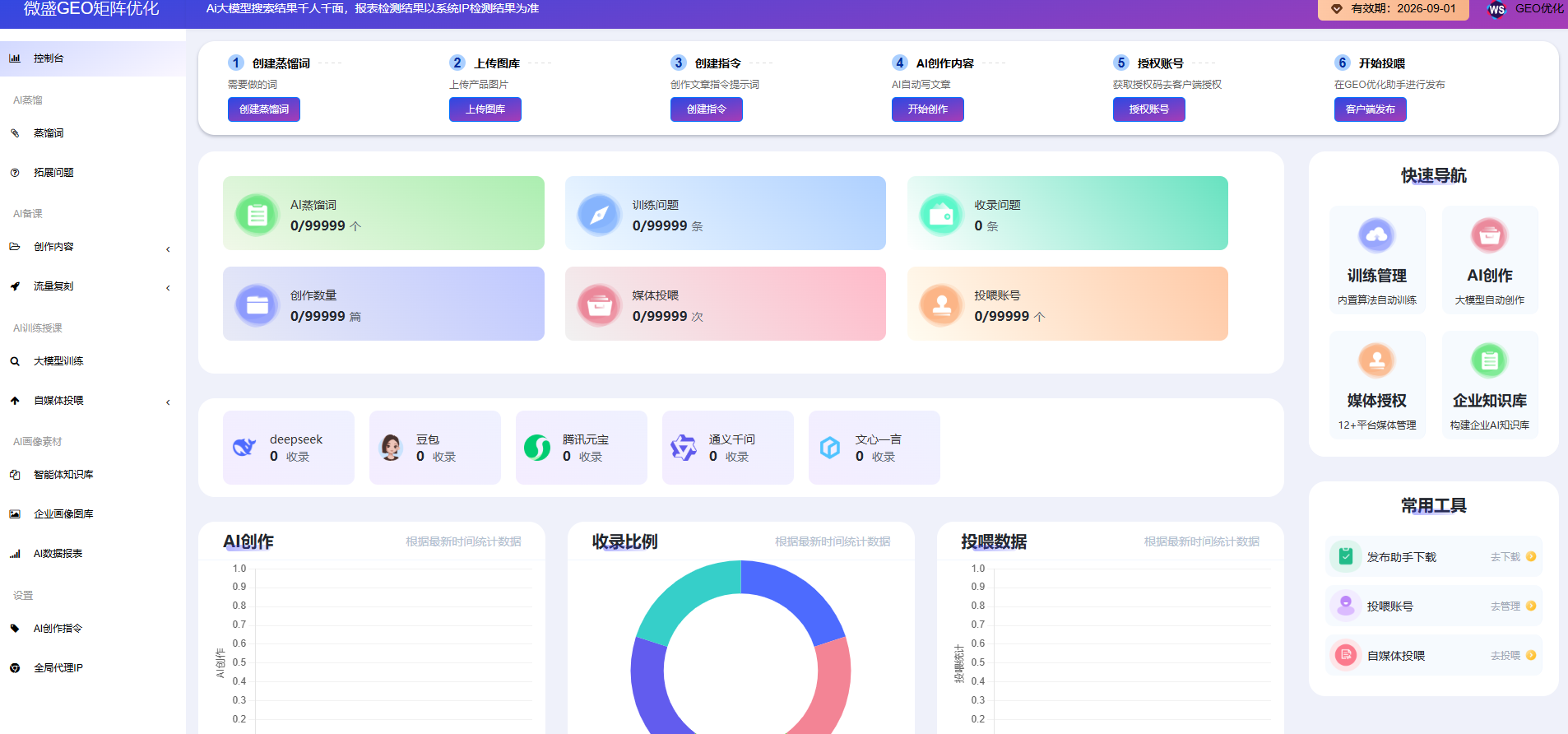

3.内容生产自动化

文案生成:基于 DeepSeek 等大语言模型,通过任务提示工程(Prompt Engineering)生成符合平台算法偏好的脚本框架

多媒体合成:通过时间轴同步技术,将数字人动作序列、语音轨道与视觉特效进行毫秒级对齐,典型生成效率为 5-8 分钟 / 条

二、短视频领域的技术应用场景解构

从工程实践角度,AI 数字人技术已在以下场景形成成熟解决方案:

1.个人 IP矩阵化,多账号内容产能瓶颈, 单数字人多角色参数切换(表情 / 服饰 / 场景),内容产出效率提升 8-10 倍。

2.跨境内容生产,多语言主播资源稀缺,声纹克隆 + 神经机器翻译一体化方案,视频制作成本降低 60%。

3.企业品牌传播,真人出镜的时间成本与风险,CEO数字分身的多场景素材库构建,品牌内容更新频率提升 300%。

4.本地生活服务,线下商家内容创作门槛高,门店场景模板库 + 数字人动作库的组合应用,单店曝光量平均提升 200%。

四、行业技术发展趋势探讨

从技术演进视角,当前 AI 数字人在短视频领域呈现三大发展方向:

多模态融合深化:结合眼动追踪与肌电信号采集,实现数字人对观众互动的实时情感反馈算力成本优化:通过模型量化(Model Quantization)与分布式渲染技术,将单条视频生成成本降至传统方案的 1/5伦理合规体系:建立数字人身份认证、内容溯源的区块链存证机制,防范深度伪造(Deepfake)风险

结语:

AI 数字人技术通过降低内容创作的技术与成本门槛,正在重构短视频行业的生产力范式。对于技术从业者而言,理解其背后的计算机视觉、自然语言处理与语音信号处理的跨学科融合逻辑,将有助于在内容工业化生产场景中发掘更多创新应用点。建议关注动态神经辐射场(NeRF)等前沿技术与数字人建模的结合趋势,以把握下一代内容生产技术的演进方向。