关于 Face 模型部署,咱先简单说说 Face 模型是处理自然语言处理等好多任务的超厉害的工具!它让咱用预训练好的模型变得非常方便。可以做像文本生成,文本分类啊这些各种常见的事。

咱现在讲讲核心的东西

1. 开发前准备阶段

得先弄好环境。系统呀得选主流的,像Linux 系统就挺靠谱的。软硬件得搭配好。硬件像GPU,那可是加快计算速度老重要的东西。软件就得装必备的,像,版本最好是3.6及以上,还要用合适的包管理工具,比如pip,在环境里装上 Face的等一系列需要的库。

数据也得弄妥当。数据好比建筑的地基,要干净整齐才行。就得找好数据源,进行格式转换、数据质量的检查、缺失值的处理这些活。要是训练微调,还得好好做数据分割成训练集和验证集这些事。

2. 模型选择步骤

Face上有超多预训练模型的。得从好多方面考虑选适合自己的。得根据自己的具体任务,像文本生成任务也许就适合GPT系列这样擅长生成的模型,文本分类的话BERT 这样的也就够好。还得考虑计算资源、模型性能,要是资源有限,就得选小点、跑得快的那种模型。

模型确定下来之后,就把那预训练的模型文件导进来,导的时候得保证完整性和兼容性。

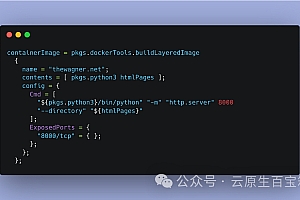

3. 模型加载以及定制调整操作

加载模型就是用库载入咱选好的模型。这库有写好的容易用的API 命令。载入的时候可以用不同模式,像只加载模型权重呀。

要想让模型更适配咱自己手头的项目,就得做定制。像是模型的结构这块,修改层数,隐藏层大小这些。还有训练参数的设置调整,学习率到底该设多大,批次大小设定好,训练的轮数计划好。

4. 训练和微调的流程展开

预训练模型还不能完全符合实际需求。必须在自己数据上调整、磨合。这训练技巧里还涉及像学习率调控,按照训练情况动态变化它。

训练结束要做评估。不同任务有不一样的评价指标。文本分类就用准确率、召回率这种评价一下。从多个纬度评价才准。要是评出来结果不好,还得看看是哪的毛病得返工。

5. 优化提速部分

要是计算资源受限或者希望推理快一点,就有优化技术登场。量化技术就是把这浮点型的转为整型,可以让模型变得小,减少内存占用,计算速度更快。然后剪枝,把模型里作用小的权重啥的去掉,不过要保证性能不掉。

另外并行训练那也有讲究。数据并行和模型并行,数据并行就是把数据分到不同计算单元训练,模型并行就是把模型结构切到不同的地方计算,各有优势得根据自己实际来选。

咱们再来整点常见问答

问: Face部署是不是必须用GPU

答:不是非得用GPU的!CPU也是可以运行的,不过效率就差不少了。要是数据量小,只是跑个简单小任务像做本地测试之类的也够了。但要是大规模的训练和频繁的推理那就选GPU了。不然真是慢得捉急!

问:选轻量级模型还是完整预训练模型好?有啥区别

答:要是计算资源有限,任务难度不那么大,选轻量级模型最合适了,加载快,占用资源也少。可要是任务真的很难,高精度又要求很关键,就得用完整预训练模型虽然它占资源和用时上可能差点劲,但能给咱高质量高水平结果!

我觉得, Face 模型部署这事真得好好琢磨。按照正确步骤细心部署,准能让咱高效利用这些模型,在各种自然语言处理方面大大发挥作用!